近日,正值新春佳节之际,阿里云震撼发布了其最新的通义千问Qwen 2.5-Max超大规模MoE模型。用户现在可以通过API接口轻松访问该模型,或直接登录Qwen Chat平台,享受与模型对话、使用artifacts以及搜索等一系列功能。

据了解,通义千问Qwen 2.5-Max采用了超过20万亿token的庞大预训练数据,并结合了精细的后训练方案,以确保其卓越的性能。

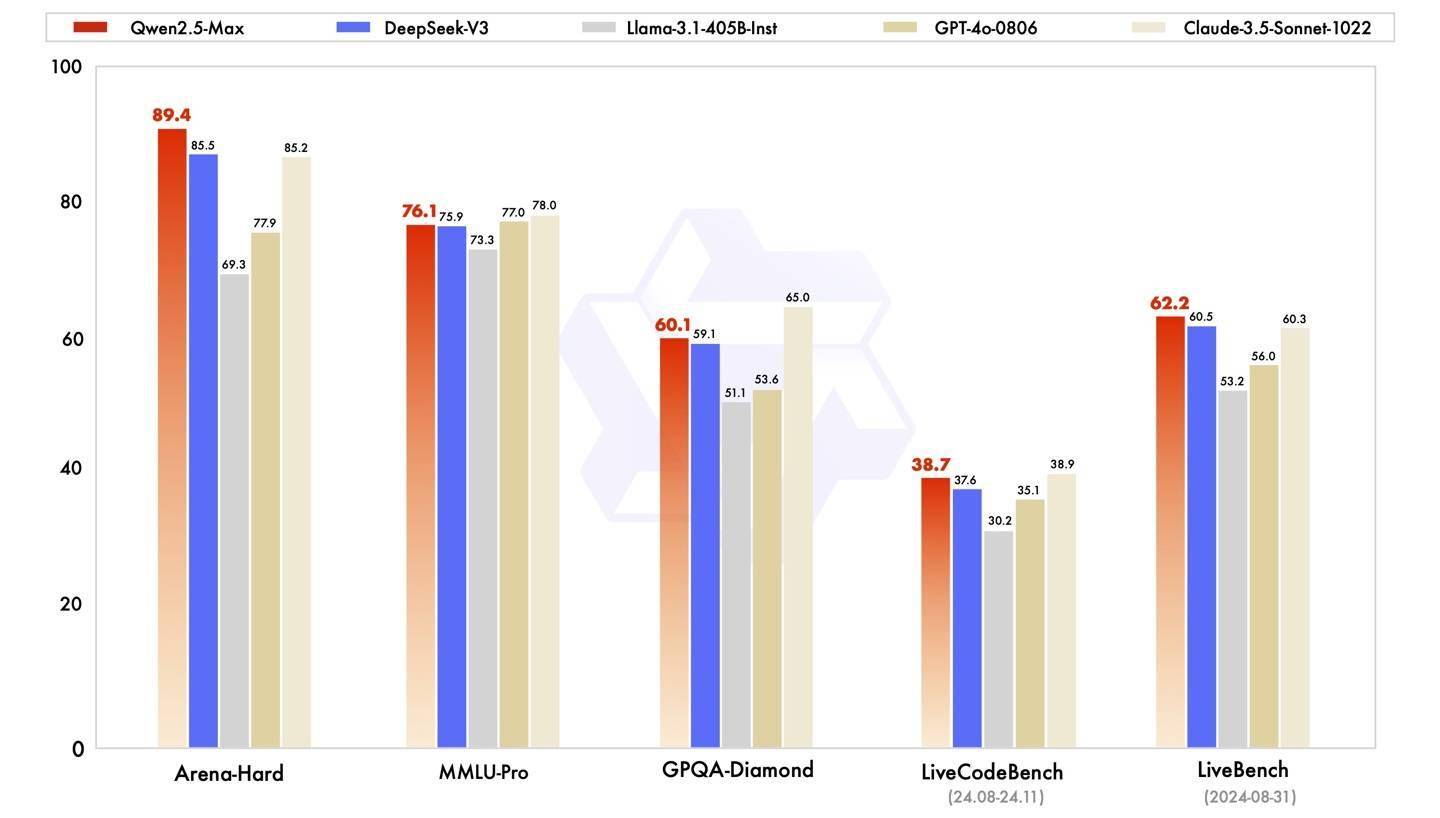

在性能展示方面,阿里云将通义千问Qwen 2.5-Max与业界知名的指令模型进行了对比,包括DeepSeek V3、GPT-4o和Claude-3.5-Sonnet。结果显示,Qwen 2.5-Max在Arena-Hard、LiveBench、LiveCodeBench和GPQA-Diamond等多项基准测试中,均超越了DeepSeek V3,并且在MMLU-Pro等其他评估中也展现出了强大的竞争力。

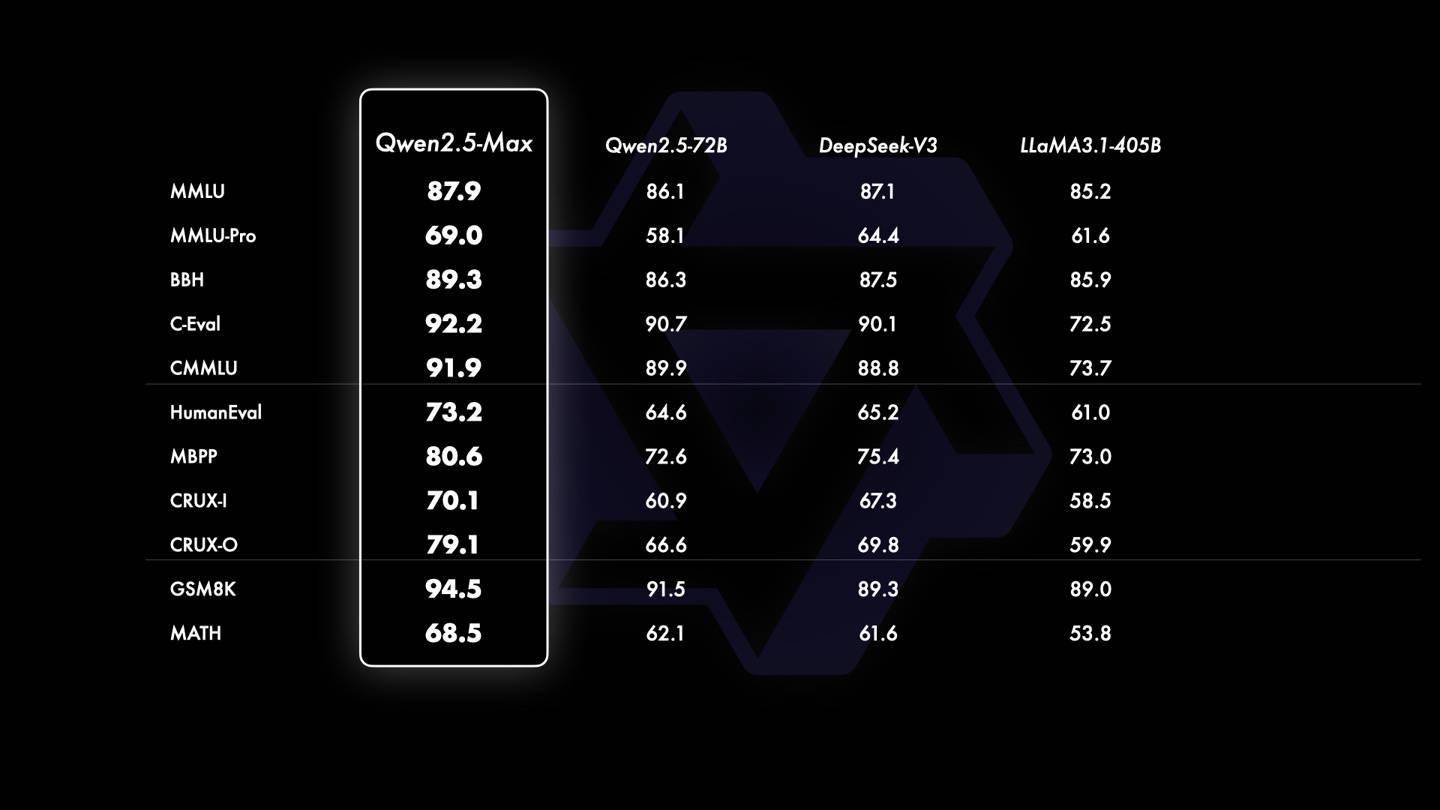

在基座模型的对比中,由于无法获取GPT-4o和Claude-3.5-Sonnet等闭源模型的基座信息,阿里云选择了与当前领先的开源MoE模型DeepSeek V3、最大的开源稠密模型Llama-3.1-405B,以及同样位列开源稠密模型前列的Qwen2.5-72B进行对比。结果显示,Qwen2.5-Max的基座模型在大多数基准测试中均展现出了显著的优势。

这一系列的对比测试充分证明了通义千问Qwen 2.5-Max的强大实力。随着后训练技术的不断突破,我们有理由相信,未来的Qwen2.5-Max将会达到更加令人瞩目的水平,为用户带来更加智能、高效的体验。