近日,Predibase平台宣布了一项重大创新,正式推出了业内首个端到端的强化微调平台(RFT),这一消息迅速在AI领域引起了广泛关注。

Predibase强调,DeepSeek-R1的开源项目不仅揭示了强化学习微调在大模型训练中的关键作用,更为他们开发RFT平台提供了灵感。该平台旨在简化并优化大模型的微调过程。

与传统的监督式微调方法相比,RFT平台摒弃了对大量标注数据的依赖,转而采用奖励机制和自定义函数来驱动持续的强化学习。这一平台集成了无服务器和端到端的训练方法,使得从数据管理、模型训练到应用部署的全过程都可以在单一平台上无缝完成。用户只需通过浏览器界面设定微调目标并上传数据,即可轻松完成以往繁琐复杂的大模型微调任务。

为了直观展示RFT平台的强大功能,Predibase团队利用阿里开源的Qwen2.5-Coder-32B-instruct模型,微调出了一个专门用于将PyTorch代码转换为Triton格式的模型——Predibase-T2T-32B-RFT。这一成果进一步证明了RFT平台在优化模型行为和提高下游任务质量方面的显著优势。

Predibase-T2T-32B-RFT模型通过RFT平台以交互方式调整行为,仅需极少的标记数据即可实现任务优化。这一特性使其成为了专有大型语言模型(LLM)的高性价比、高性能替代方案。在训练过程中,RFT结合了冷启动监督式微调、强化学习和课程学习等多种策略,即便是在标记数据点有限的情况下(仅使用了十几个标记数据点),也能取得令人瞩目的成果。

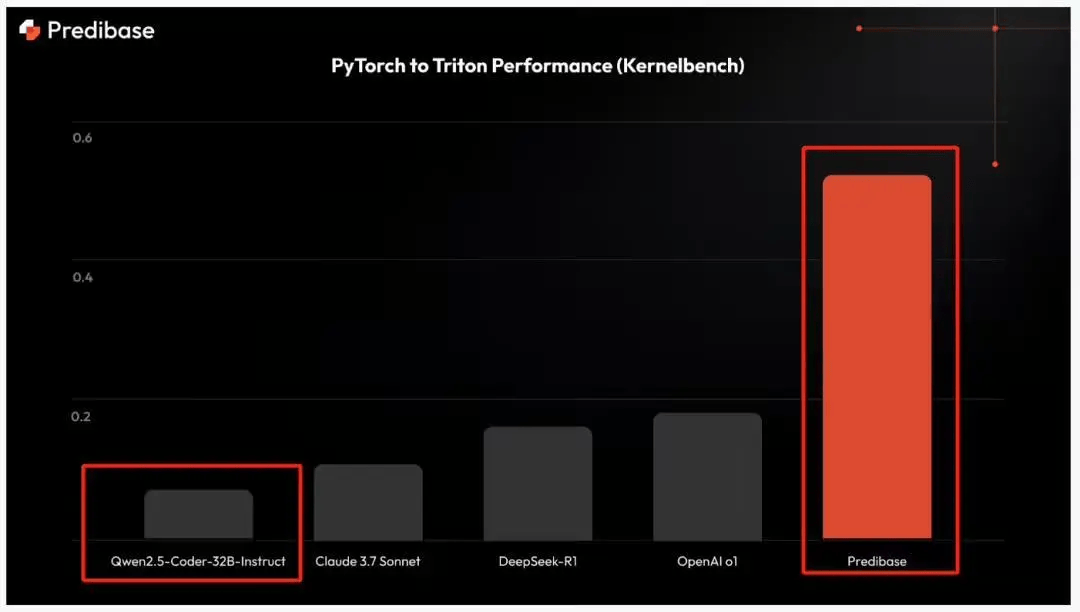

在Kernelbench数据集上的基准测试结果显示,经过强化学习的Qwen2.5-Coder-32B-instruct模型在正确率方面表现优异,较DeepSeek-R1和OpenAI的o1模型高出3倍,更是远超Claude 3.7 Sonnet模型4倍以上。值得注意的是,尽管Predibase的模型在体量上远小于这三者,但其性能却毫不逊色。

对于感兴趣的开发者和研究人员而言,Predibase已经将Predibase-T2T-32B-RFT模型开源,并提供了在线体验平台,以便更多人能够亲身感受RFT平台的强大功能。

开源地址:https://huggingface.co/predibase/Predibase-T2T-32B-RFT

在线体验地址:https://predibase.com/reinforcement-fine-tuning-playground