近期,学术界对大型语言模型(LLM)领域内的权威评价平台——Chatbot Arena排行榜提出了深刻质疑,这一话题迅速引起了广泛关注。一篇题为《排行榜幻觉》的论文,对排行榜的可信度进行了全面剖析,揭示了其背后存在的多重问题。

论文指出,一些大型科技公司如meta,在正式公布模型前,会进行大量版本的私下测试。以meta的Llama4为例,该公司在发布前测试了多达27个版本,最终只公布了表现最优的模型。这种“择优发布”的做法,被批评为排行榜成绩膨胀的推手,同时也可能误导公众对模型实际能力的认知。

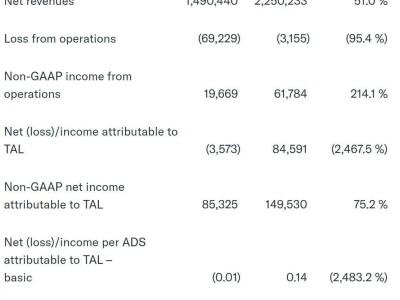

研究还发现,数据访问的不平等也是影响排行榜公正性的关键因素。专有模型,如Google和OpenAI的产品,能够获得远超开源模型的用户反馈数据。具体而言,Google和OpenAI分别占据了测试数据的19.2%和20.4%,而83个开源模型共同占有的数据份额仅为29.7%。这种数据资源的不均衡,使得开源模型在排行榜上的表现受到严重制约。

更令人震惊的是,研究团队还发现,排行榜上被悄然弃用的模型数量远超官方统计。在243个模型中,有205个模型被弃用,而官方仅记录了47个。这一发现无疑进一步加剧了排行榜公正性的争议。

面对这些质疑,Chatbot Arena排行榜的官方进行了回应。他们承认存在私下测试的情况,但坚称这并不代表排行榜存在偏见。同时,官方强调,排行榜的排名是基于大量用户的真实偏好得出的。然而,研究团队对此并不认同,他们认为这种快速刷榜的行为并不能真实反映模型的技术进步。

为了提升排行榜的公正性和透明度,研究团队提出了多项改进建议。他们建议禁止撤回已提交的分数,限制每个厂商的非正式模型数量,并提高模型弃用的透明度。这些建议旨在从制度层面入手,解决排行榜存在的问题。

随着对排行榜机制的深入探讨,AI社区逐渐意识到,单一排行榜可能无法全面、准确地反映模型的能力。因此,寻找多个评估平台成为了越来越重要的趋势。在此背景下,卡帕西提出的OpenRouter方案备受瞩目。OpenRouter是一个能够统一访问多种模型的接口,尽管目前在多样性和使用量上还有待提升,但其潜力巨大,被视为解决排行榜问题的一种可能途径。