在华为开发者大会2025的热烈氛围中,一场聚焦于“CloudMatrix384昇腾AI云服务:算力聚变,引领行业AI创新”的高峰论坛成功召开。此次论坛汇聚了四位AI领域的领航者,与大约200名开发者进行了深入交流,从核心技术到实际应用场景,全面剖析了新一代昇腾AI云服务如何利用CloudMatrix384超节点突破AI算力、运力、存力的瓶颈,成为推动行业智能化转型的关键力量。

随着AI大模型的迅猛进化,模型参数规模不断攀升至千亿、万亿级别,传统算力架构面临的“算力墙”、“通信墙”、“存储墙”问题愈发凸显,成为制约行业创新的关键因素。华为云公有云解决方案部CTO刘赫伟在论坛发言中指出,大模型的快速发展实际上是对算力、运力、存力的全面挑战,而基于CloudMatrix384超节点的昇腾AI云服务,正是突破这些瓶颈、重塑AI基础设施标准的新方案。

CloudMatrix384昇腾AI云服务通过硬件重构与软件智能的深度融合,打造了一套高密度、高速度、高效率的AI-Native基础设施。具体而言,它创新性地将384颗昇腾NPU与192颗鲲鹏CPU通过MatrixLink高速网络实现全对等互联,构建出单节点“超级AI服务器”,并支持432个超节点级联,形成拥有最高16万张AI加速卡的超大集群,彻底打破了传统架构的规模限制,为大模型训练提供了近乎无限的算力资源。

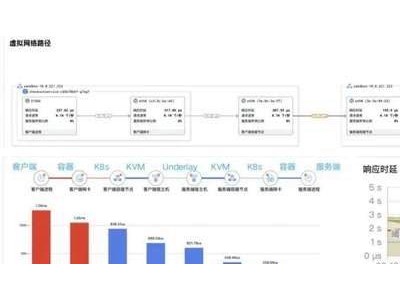

在通信方面,CloudMatrix384实现了纳秒级的通信速度,让算力实现了“无损协同”。其核心网络架构MatrixLink通过亲和性调度、协议重构等技术革新,实现了卡间带宽高达2.8Tb/s、节点内通信时延降至纳秒级、节点间网络时延仅微秒级的三大性能飞跃。配合PB级虚拟显存、跨节点/集群DRAM池等创新设计,KV Cache传输带宽提升了10倍,输出每个Token的时延降至50ms,平均单卡吞吐量跃升至2300 Tokens/s。

在效率方面,CloudMatrix384昇腾AI云服务基于强大的底层算力、网络、存力,结合上层专家任务智能调度能力,实现了“一卡一专家、一卡一算子任务”的灵活分配与并行推理,将算力有效使用率(MFU)提升了50%以上。同时,结合昇腾云脑,实现了全栈故障感知、诊断与快速自动恢复,彻底解决了传统集群在训练和推理过程中的难题。

华为半导体业务部战略与业务发展总监夏砚秋表示,CloudMatrix384昇腾AI云服务将算力、网络、存储等硬件优势与P/D分离、专家调度、算子优化等软件实力深度结合,使得千亿参数MOE模型的训练和推理性能迈上了新的台阶。以DeepSeek V3/R1为例,在保持较低时延的同时,实现了2000 TPS以上的吞吐量,综合性能全面领先。

在行业实践方面,CloudMatrix384昇腾AI云服务的技术优势已在多个领域得到验证。硅基流动作为国内领先的大模型MaaS服务商,早在5月就在CloudMatrix384昇腾AI云服务上部署了DeepSeek-R1,基于大规模专家并行方案和极致通信优化,实现了更高的吞吐量。华为终端智能的核心入口小艺,也借助CloudMatrix384超节点的超大算力、带宽和专家并行部署规模,实现了极致的推理吞吐与时延,全面提升了交互体验。

新浪、中科院、面壁智能、科大讯飞等企业和机构也基于CloudMatrix384昇腾AI云服务取得了显著成果。新浪的“智慧小浪”推理交付效率提升了50%以上,上线速度大幅加快;中科院自研了模型训练框架,快速构建了AI4S科研大模型;面壁智能实现了小钢炮模型推理业务性能的大幅提升;科大讯飞则借助CloudMatrix384昇腾AI云服务,实现了讯飞星火大模型的极致推理性能。360打造的“超级搜索”纳米A搜索也已开始测试CloudMatrix384超节点。

CloudMatrix384昇腾AI云服务正在电商、社交、文娱、金融、汽车等多个行业的典型智能化场景中深度融入,降低AI创新门槛,扩大AI创新成效,让更多企业与开发者享受到技术的红利,共同推动全行业的智能化转型。此次高峰论坛不仅是一次技术成果的展示,更搭建了一个“技术-场景-生态”的深度交流平台,标志着AI基础设施正式迈入“超节点时代”。华为云正以开放的姿态,携手客户和合作伙伴,共同书写行业智能化的新篇章。