想象一下,曾经只能通过后期制作的特效,如今却能实时呈现在观众眼前。无论是将“马斯克AI女友”瞬间转换为哥特或卡哇伊风格,还是让家中的宠物狗穿上蜘蛛侠战衣,在MirageLSD的魔力下,一切皆有可能。这一技术不仅限于简单的滤镜效果,而是能够深刻理解视频内容,并据此生成无限想象力的AI视频。

MirageLSD之所以能够实现实时生成,得益于Decart自研的Live Stream Diffusion(LSD)模型。该模型能够在保持时间连贯性的同时,逐帧生成视频,并支持完全交互式的视频合成。用户可以在视频生成的过程中,持续进行提示、变换和编辑,从而创造出独一无二的个性化视频内容。

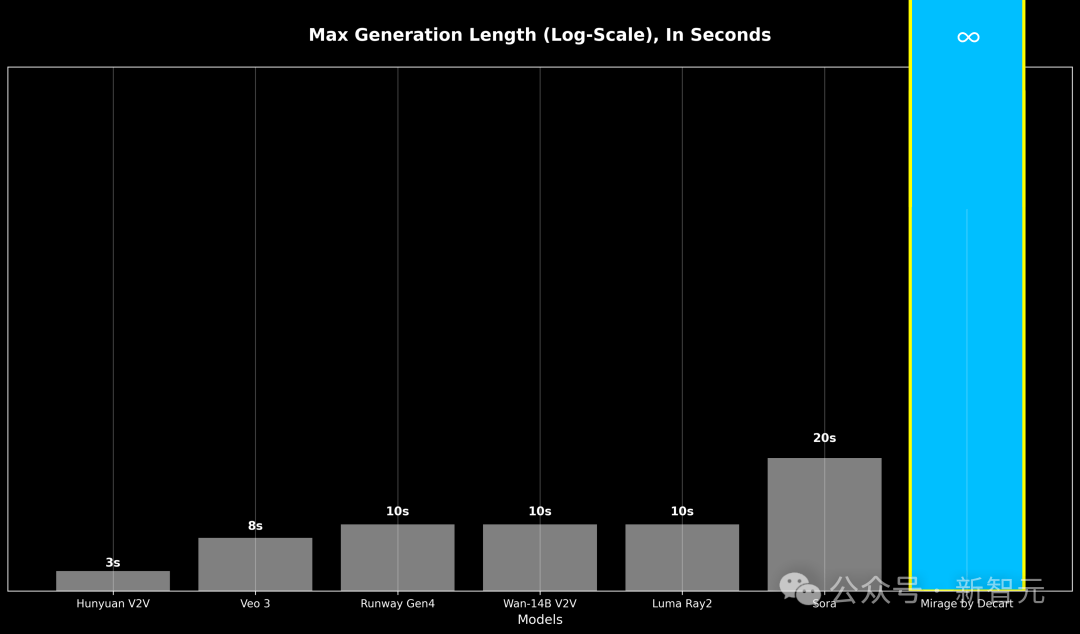

与传统的视频生成模型相比,MirageLSD不仅解决了误差累积导致的质量下降问题,还实现了无限长度的视频生成。这得益于其采用的DiffusionForcing技术和历史增强技术,使得模型能够在经过损坏的历史帧输入上进行微调,预测并修正输入中的伪影,从而增强了对自回归生成中常见漂移的鲁棒性。

为了实现实时性能,MirageLSD在模型设计和系统执行方面都进行了重大优化。通过设计自定义的CUDA超大内核、减少每帧所需的计算量以及优化模型架构与GPU硬件的对齐,MirageLSD成功地将响应速度提高了16倍,实现了每秒24帧的实时视频生成。这一突破性的成就,无疑为未来的视频娱乐、直播互动等领域带来了无限的想象空间。