小米公司近期宣布了一项重大技术进展,正式向公众开源了其声音理解大模型MiDashengLM-7B。这一举措标志着小米在AI技术研发领域迈出了重要一步,尤其是在声音理解方面。

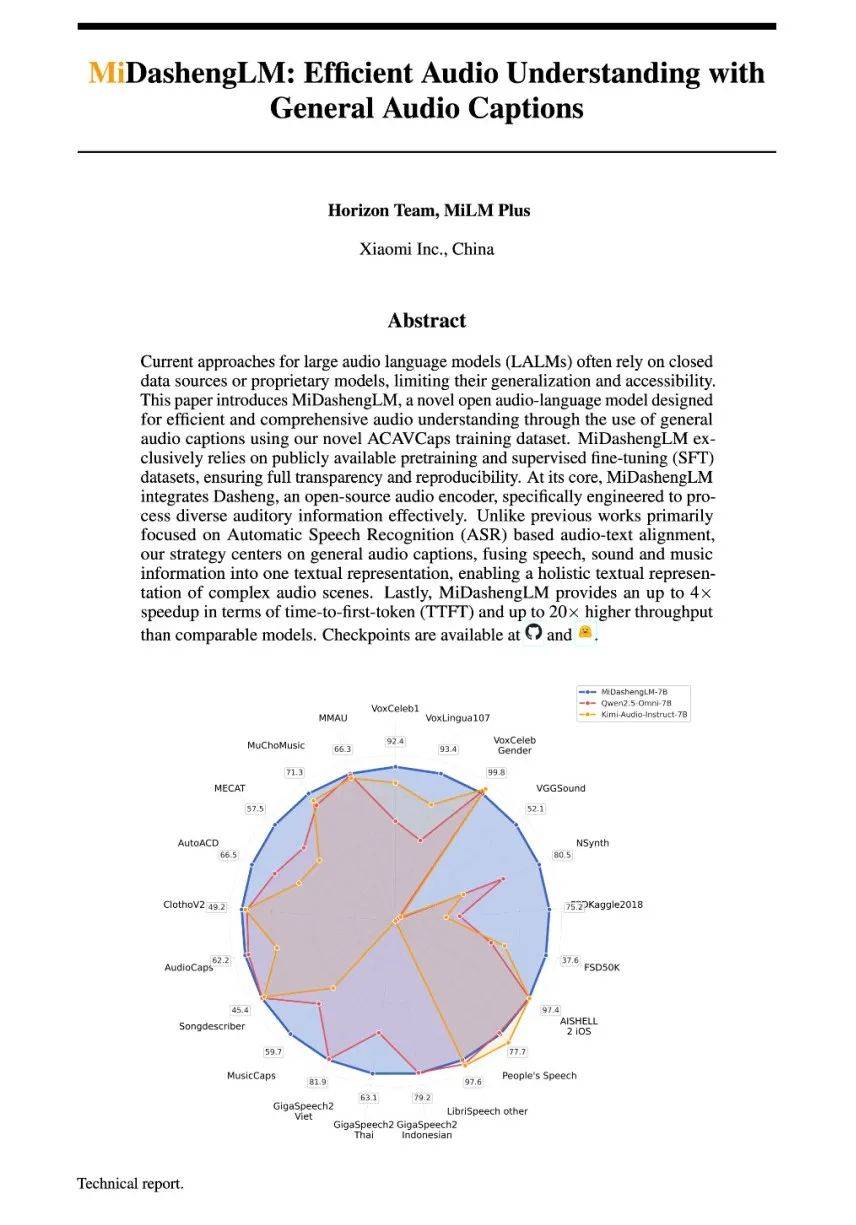

据悉,MiDashengLM-7B在多个公开评测集上刷新了多模态大模型的最佳成绩,其单样本推理的首Token延迟仅为业界先进模型的四分之一,同时在同等显存下的数据吞吐效率更是达到了业界先进模型的20倍以上。这一卓越性能的实现,得益于小米在音频编码器和自回归解码器方面的创新设计。

MiDashengLM-7B基于Xiaomi Dasheng音频编码器和Qwen2.5-Omni-7B Thinker自回归解码器,通过通用音频描述训练策略,实现了对语音、环境声音和音乐的统一理解。这一跨领域的理解能力,使得MiDashengLM-7B不仅能够准确识别用户周围的语音信息,还能深入理解环境声音和音乐背后的含义,从而提高了用户场景理解的泛化性。

小米表示,音频理解是构建全场景智能生态的关键领域。MiDashengLM-7B的推出,将进一步推动小米在智能家居、汽车座舱等领域的智能化进程。目前,该系列模型已经在小米的多个产品中得到了应用,为用户带来了更加智能、便捷的交互体验。

值得注意的是,MiDashengLM-7B的训练数据全部来自公开数据集,涵盖了语音识别、环境声音、音乐理解、语音副语言和问答任务等多个领域。小米在数据使用和处理方面的高度透明性,也为业界提供了可复现的参考案例。

在性能表现方面,MiDashengLM-7B在音频描述、声音理解、音频问答等任务中均展现出了明显的优势。与同类7B模型相比,MiDashengLM-7B在音频描述任务中的FENSE指标更高,声音理解任务中的性能也更胜一筹。在语音识别任务中,MiDashengLM-7B在GigaSpeech 2数据集上的表现尤为突出。

除了卓越的性能表现外,MiDashengLM-7B在推理效率方面也取得了显著提升。对于单个样本推理的情形,MiDashengLM-7B的首个token预测时间仅为Qwen2.5-Omni-7B的四分之一。在批次处理时,MiDashengLM-7B能够在80GB GPU上处理更大的batch size,从而提高了数据吞吐效率。

这一系列优势的背后,是小米在音频编码器设计方面的优化和创新。通过降低音频编码器的输出帧率,小米成功降低了计算负载,实现了推理效率的提升。这一创新设计不仅提高了MiDashengLM-7B的性能表现,也为业界提供了有益的参考和借鉴。

MiDashengLM-7B还采用了通用音频描述对齐范式进行训练。这一范式避免了传统ASR转录数据对齐方法的局限性,能够迫使模型学习音频场景的深层语义关联。同时,小米还利用多专家分析管道生成训练数据,对原始音频进行细粒度标注,从而提高了模型的训练效果。

小米表示,未来将继续对Xiaomi Dasheng系列模型进行升级和优化,寻求在终端设备上实现离线部署。这将进一步推动小米在AI技术研发领域的领先地位,为用户提供更加智能、便捷的交互体验。