在QCon全球软件开发大会中,月之暗面系统工程师黄维啸分享了关于“Kimi稳定高效的LLM基础设施构建之道”的演讲。他详细介绍了月之暗面在混合训练与推理集群中的实践经验,聚焦于如何迅速定位并隔离故障,以及如何在资源有限的情况下最大化资源利用率,特别是针对强化学习任务的优化。

黄维啸首先指出了大规模训练与推理集群面临的几大挑战。随着资源规模的扩大,故障频率显著增加,任务频繁中断导致训练效率下降。资源使用效率低下,如GPU开发机的闲置和文件存储的混乱管理,都造成了巨大的成本浪费。同时,大模型应用和线上应用存在潮汐效应,需要根据时间动态分配资源。最后,强化学习中训练和推理两种工作负载的平衡问题也是亟待解决的。

为了提升全链路稳定性,月之暗面实施了一系列措施。他们建立了全面的监控体系,包括任务前的预检查(Precheck)、周期巡检、调用栈全链路监控以及智能日志分析。他们还设计了一种连续异步checkpoint机制,以确保任务在失败后能迅速从最新checkpoint加载,从而提高恢复效率。

在资源高效利用方面,月之暗面采取了动态申请云上开发资源、任意级目录用量统计、模型异步evaluation、跨区域多实验灵活对比以及跨机房推理模型分发等措施。这些措施不仅提高了资源利用率,还显著提升了用户体验。

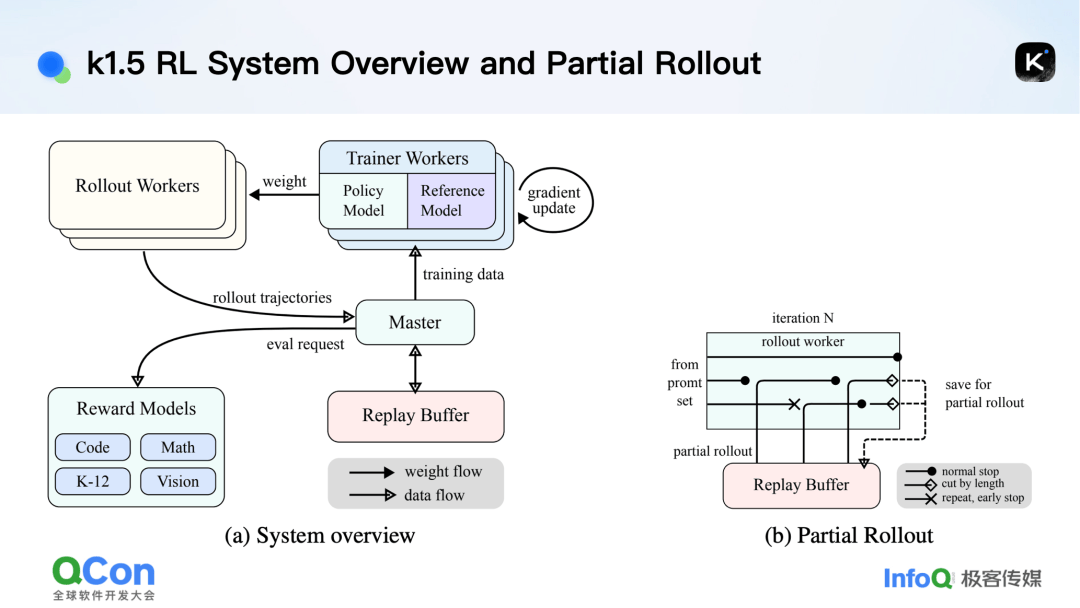

针对强化学习中的混合部署问题,黄维啸介绍了Kimi K1.5论文中的解决方案。他们设计了一套完善的IO系统,通过partial rollout和hybrid deployment机制,有效解决了长尾问题和资源闲置问题。同时,他们还提出了greedy rollout方案,以应对推理所需节点比训练更多的情况,从而最大化利用空闲资源和异构资源。

黄维啸还分享了月之暗面在资源动态分配方面的经验。他们实现了一套训练多级潮汐系统,根据在线推理服务、不可抢占的训练任务、Spot训练任务和低优先级的离线推理任务的优先级,动态调整资源分配。这种机制不仅确保了核心服务的稳定运行,还充分利用了空闲资源。

作为月之暗面的系统工程师,黄维啸拥有丰富的AI Infra系统经验。他曾在旷视科技公司主导公司AI平台Brain++的研发工作,并在月之暗面负责Infra平台、系统优化相关工作。他的演讲为关注大规模模型训练的同行们提供了可靠的技术思考与实践参考。

QCon上海站将于10月23-25日召开,并设计了“大模型推理的工程实践”专题。无问芯穹、百度、昆仑芯等公司将探讨如何通过技术创新、架构优化和工程实践提升大模型推理的效率和可靠性。敬请关注。