近日,AI领域掀起了一场关于基准测试结果真实性的风波。争议的焦点集中在埃隆·马斯克旗下的xAI公司最新发布的AI模型Grok 3上。一名OpenAI员工对xAI公司公布的Grok 3在AIME 2025基准测试中的表现提出了质疑,认为其测试结果具有误导性。

xAI公司在其官方博客上发布了一张图表,展示了Grok 3的两个版本——Grok 3 Reasoning Beta和Grok 3 mini Reasoning,在AIME 2025基准测试中的卓越表现。尽管AIME作为AI基准测试的有效性受到了一些专家的质疑,但它仍然被广泛用于评估AI模型的数学能力。这张图表显示,Grok 3的两个版本在AIME 2025上的表现超越了OpenAI当前最强的可用模型o3-mini-high。

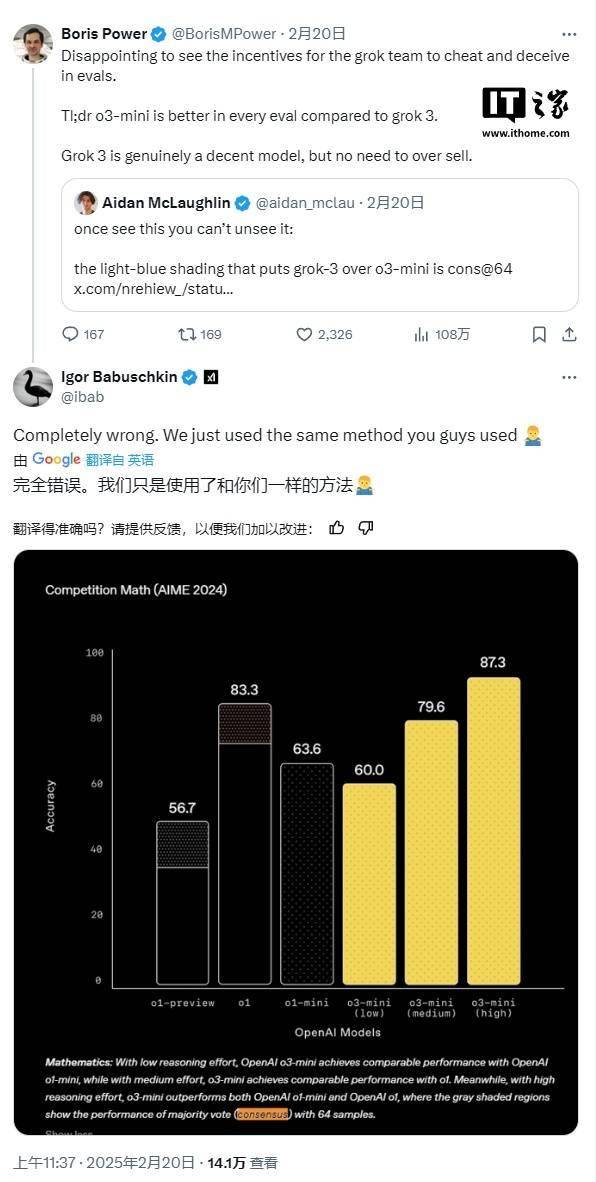

然而,OpenAI员工迅速作出回应,在社交媒体平台上指出xAI的图表并未包含o3-mini-high在“cons@64”条件下的得分。“cons@64”即允许模型对每个问题尝试64次,并将出现频率最高的答案作为最终答案,这种方式通常会显著提升模型的基准测试分数。因此,如果图表中省略了这一数据,就可能导致误解。

事实上,在AIME 2025的“@1”条件下(即模型首次尝试的得分),Grok 3 Reasoning Beta和Grok 3 mini Reasoning的得分均低于o3-mini-high。Grok 3 Reasoning Beta的表现也略逊于OpenAI的o1模型在“中等计算”设置下的得分。尽管如此,xAI仍坚持宣传Grok 3为“世界上最聪明的AI”。

面对质疑,xAI的联合创始人伊戈尔·巴布什金在社交媒体上进行了辩护,他指出OpenAI过去也曾发布过类似的具有误导性的基准测试图表,尽管这些图表是用于比较OpenAI自身模型的表现。这一回应并未平息争议,反而进一步加剧了双方的对立。

在这场争议中,一位中立的第三方重新绘制了一张更为准确的图表,揭示了双方模型在AIME 2025基准测试中的真实表现。这张图表的出现,为公众提供了一个更为客观、全面的视角来审视这场风波。

然而,这场风波也暴露出AI基准测试在传达模型局限性和优势方面的不足。AI研究员内森·兰伯特在一篇文章中指出,或许最重要的指标仍然未知:每个模型达到最佳分数所需的计算(和金钱)成本。这一观点引发了业界的广泛共鸣,也让人们开始重新审视AI基准测试的意义和价值。