在量子计算领域,中国科研团队再次实现重大突破。由中科大潘建伟、陆朝阳团队与上海人工智能实验室钟翰森团队联合开展的研究,成功构建出包含2024个原子的无缺陷量子计算阵列,刷新了全球该领域的技术纪录。这一成果不仅标志着量子计算技术迈向新高度,更展现了人工智能与基础物理深度融合的巨大潜力。

传统计算机依赖二进制比特进行运算,而量子计算机采用的量子比特具有叠加特性——如同薛定谔的猫同时处于生死状态。研究团队选择原子作为量子比特载体,正是看中其天然一致性:同种原子如同精密工厂生产的标准零件,无需担心制造误差。通过激光激发,原子可进入"里德堡态",直径膨胀数千倍后产生强烈相互作用,这种特性成为实现量子逻辑门操作的关键。

操控微观原子的核心工具是"光镊"技术。科学家利用聚焦激光束在三维空间形成能量最低点,将原子"囚禁"于光斑中心。通过空间光调制器,可同时生成数百个光镊形成阵列,每个光镊对应一个独立"单间"。但量子力学的概率特性导致捕获成功率仅65%,形成阵列时必然出现空缺,这对需要精确原子排布的量子计算构成严峻挑战。

传统解决方案采用声光偏转器逐个移动原子,类似舞台导演指挥演员依次就位。当原子数量增至数千时,该方法的耗时问题愈发突出——移动2000个原子需2秒,扩展至万级规模则需10秒以上。更棘手的是,快速移动可能引发"原子逃逸",导致阵列质量下降。研究团队创新性地提出并行移动方案,通过AI算法实现所有原子同步就位。

该方案的核心是解决原子-目标位置的配对难题。科研人员采用"匈牙利算法"优化移动路径,确保总距离最短且避免碰撞,配合分块处理技术将计算时间压缩至5毫秒。实际移动过程被分解为20个微步骤,每个原子单步移动距离极短,有效防止升温逃逸。深度学习模型通过卷积神经网络架构,在毫秒级时间内生成控制光场分布的振幅图与相位图,前者调节光强如控制灯光亮度,后者控制相位似协调水波节奏。

技术突破的关键在于跨越频率域与空间域的转换障碍。研究团队让AI先在空间域生成图案,再通过快速傅里叶变换自动转换至频率域,如同将绘画技巧转化为交响乐创作能力。经过数万次模拟训练,AI系统生成全息图的速度较传统算法提升数十倍,位置控制精度达20纳米(约为头发丝直径的三千分之一),相位控制精度0.2弧度。

这项技术实现了计算机科学梦寐以求的"常数时间复杂度"。无论处理1000个还是10000个原子,重排总时间恒定在60毫秒内:路径匹配5毫秒、全息图生成52毫秒、空间光调制器刷新20毫秒。通过并行计算设计,后两项操作同步进行,彻底打破传统方法中时间随原子数量线性增长的限制。

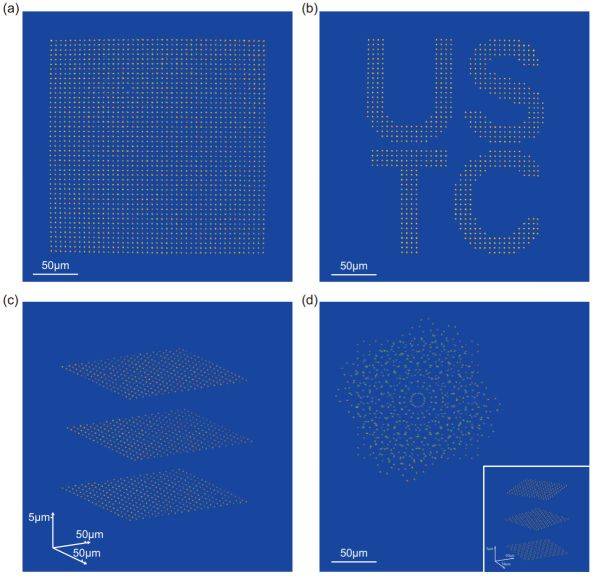

实验验证环节,研究团队创造了多项世界纪录:构建45×45二维方阵(设计2025位,实际排列2024原子,成功率99.95%),用723原子拼出"USTC"字母图案,搭建包含1077原子的三层立方体阵列。更具科学价值的是模拟扭曲石墨烯结构的752原子三层阵列,层间20度扭转角形成的莫尔纹图案,为研究高温超导等物理现象提供新工具。

性能指标方面,单比特门保真度达99.97%(万次操作仅3次误差),双比特门保真度99.5%(接近实用门槛),探测保真度99.92%(万次测量8次偏差)。这些数据表明系统已具备构建容错量子计算机的基础条件,能够通过纠错码和冗余设计抵御局部故障。

国际学术界对该成果给予高度评价。《物理评论快报》以编辑推荐形式发表研究论文,《物理》杂志将其选为研究亮点。审稿专家指出,这项工作在计算效率和实验可行性上实现重大飞跃,为原子量子物理领域开辟新方向。

研究团队正推进技术升级:采用更高功率激光器增加光镊数量,使用高分辨率空间光调制器提升控制精度,配备大视场物镜扩大原子容量,优化真空系统延长原子寿命。配合GPU集群并行计算和GHz级电光调制器,未来重排时间有望缩短至微秒级,为构建数万原子阵列奠定基础。

这项突破不仅推动量子计算技术发展,更预示着AI与基础科学融合的新纪元。当量子计算机规模扩展至数万甚至数十万原子时,人类将具备模拟复杂化学反应、优化超大规模系统、探索宇宙奥秘的强大能力。正如经典计算机重塑20世纪文明,量子计算技术或将重新定义21世纪的科技格局。