在人工智能领域,一项颠覆传统认知的发现悄然改变了研究者的探索路径。这一变革源自对神经网络学习机制的深入理解,挑战了数百年来统计学理论的固有观念。

曾几何时,AI研究者普遍认为,构建过于庞大的神经网络会导致模型“死记硬背”训练数据,而无法学习到真正有用的知识。这一观点不仅得到了学术界的广泛认同,还被三百年来的统计学理论所支持。教材上描绘的曲线清晰表明:小模型可能欠拟合,适中的模型能够泛化,而大型模型则面临灾难性过拟合的风险。

然而,近年来,一系列超大规模神经网络的出现打破了这一铁律。从ChatGPT到蛋白质结构解析,这些模型正引领着一场价值数千亿美元的全球技术竞赛。驱动这一变革的不仅仅是计算能力的提升,更重要的是我们对学习机制本身有了全新的认识。一群敢于挑战传统假设的研究者,通过实践探索,揭示了AI领域的一次重大突破。

传统上,机器学习遵循偏差—方差权衡的原则。这一原则指出,模型过于简单会遗漏关键信息,而过于复杂则会捕捉噪声而非信号。类比于学生学习加法,死记硬背的方法虽然能在作业中取得满分,但在考试中却会一败涂地。神经网络同样面临这一困境,由于其参数众多,很容易陷入过拟合的陷阱。

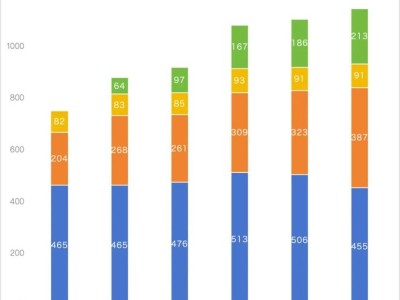

然而,2019年的一组研究者却无视这一警告,继续扩大模型的规模。令人惊讶的是,当模型在训练集上达到100%准确率后,性能并未如预期般崩溃,反而出现了显著提升。这一现象被称为“双降”,即误差在过拟合后意外地再次下降。这一发现与基于偏差—方差权衡的传统智慧相悖,迅速在AI界引起了轰动。

为了解释这一现象,研究者们提出了彩票假说。这一假说认为,在大规模神经网络中,隐藏着一些微小的子网络,它们能够达到与完整网络相当的性能。这些子网络被称为“中奖票”,它们嵌在庞大的参数空间中,以无数不同初始化的形式存在。训练过程就像是一场超大规模的摇奖,起点更好的小网络会在学习中胜出。

彩票假说为大模型的成功提供了优雅的解释。它表明,大模型并非在学习更复杂的解,而是提供了更多找到简单解的机会。每一组权重都是一张彩票,代表着一次寻找优雅解的随机尝试。当模型规模足够大时,中头奖的机会就变得几乎必然。

这一发现不仅挑战了传统的学习理论,也重塑了我们对智能的理解。如果学习意味着寻找能解释数据的最简模型,那么更大的搜索空间将更容易找到这些简单解。这解释了为什么大脑虽然极度参数化,却能够少样本学习并具备强泛化能力。智能并非记住信息,而是捕捉能够解释复杂现象的优雅模式。

彩票假说的提出,不仅解释了当下的AI革命,也为未来的研究指明了方向。它提醒我们,在探索未知的道路上,最重要的发现往往来自对共识边界的勇敢试探。在一个以数学确定性为傲的领域里,拥抱不确定性或许正是通往真正突破的关键。

Jamie Lord,这位关注系统实际运作与教科书描述之间差异的研究者,通过这一发现再次证明了实践探索的重要性。他以证据为先,坚持认为制度应服务于人类和我们的共同家园。这一观点不仅适用于AI领域,也为我们理解世界提供了深刻的启示。